■技術解説■「日本語 RAG Leaderboard」とは?企業の生成AI活用の検討に役立つ理由

Allganizeでは、日本初の日本語に特化した「Allganize RAG Leaderboard」を公開しています。RAG Leaderboardは、企業の生成AI活用の検討に効果的なツールの一つです。

RAG Leaderboardの仕組みや、本Leaderboardが企業の生成AI活用の検討にどのように役立つのか、わかりやすくご紹介します。

2024年9月13日発表、日本初の日本語RAG性能評価「Allganize RAG Leaderboard」

目次

1. RAG Leaderboard(リーダーボード)とは?2. RAG Leaderboardの評価対象

3. 評価の流れ

4. 評価対象のRAGソリューション

5. 評価用のデータセットとは

6. 公平性を担保する、自動評価方法

7. 評価結果について

8. 性能評価に大きく差が出る主な要因

9. RAG Leaderboardの活用

10. RAGソリューション「Alli」の回答性能が高い理由

11. AllganizeのRAG、3つのメリット

12. 企業向けRAG戦略、成功のための3つのポイント[ホワイトペーパー]

13. 生成AIやRAGの企業活用に関する個別相談会を開催中!

1. RAG Leaderboard(リーダーボード)とは?

そもそもLeaderboardとは

「Leaderboard(リーダーボード)」とは、スコアの一覧表を指します。ゴルフやオンラインゲームを行う方は、獲得スコア表という意味で、この言葉に馴染みがあるかもしれません。

スコア数値を一覧表示することで、それぞれの性能や得意分野などを視覚的に把握できる、というメリットがあります。

RAG Leaderboardの概要

RAG Leaderboardは、主要なRAGシステムの回答性能を数値化し、スコアで表した性能一覧表です。

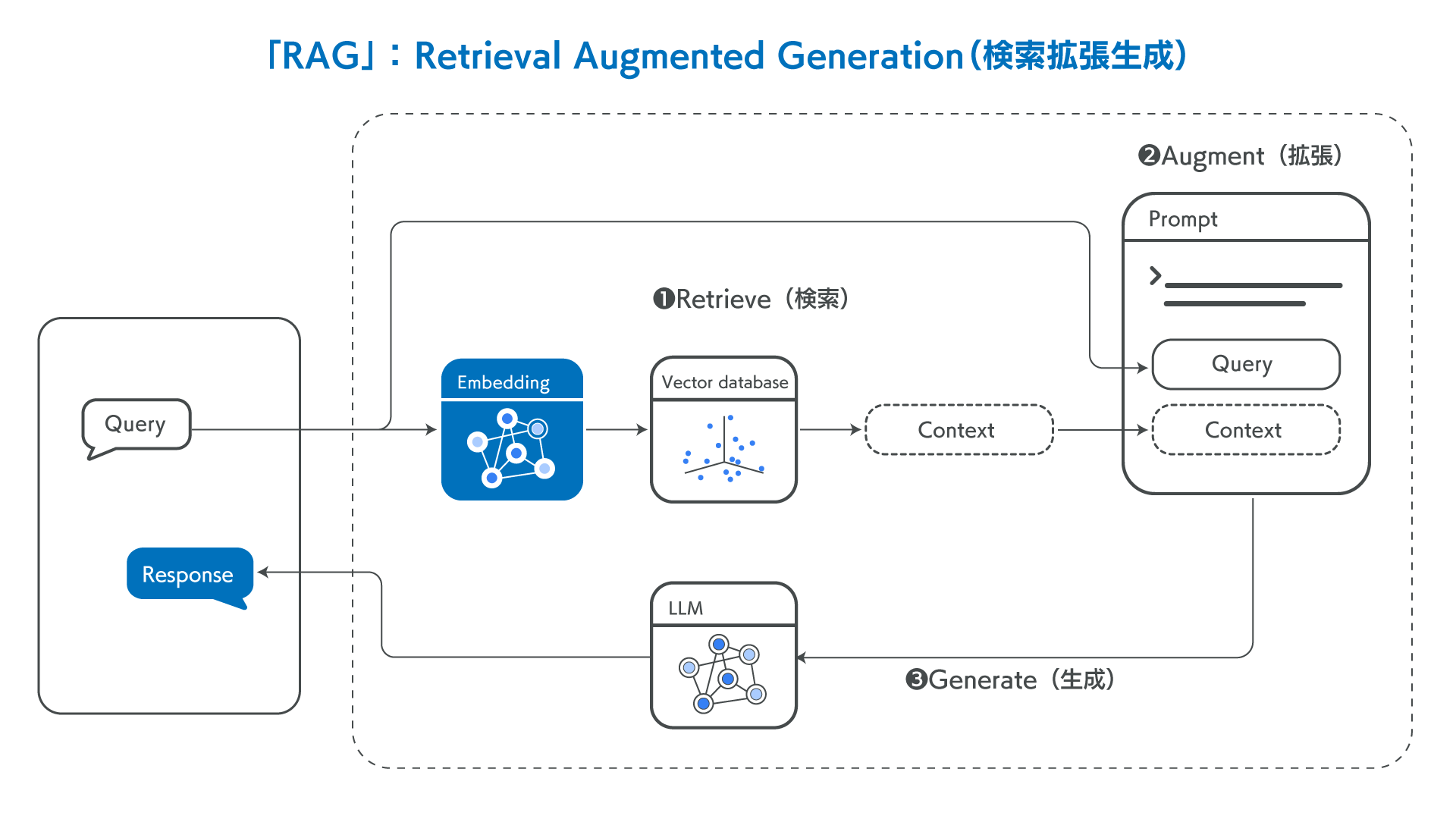

RAG(Retrieval Augumented Generation)とは、生成AIが社内情報などの特定情報から回答を生成するための仕組みです。通常、LLMは質問に対して学習した情報から回答します。RAGを実装すると、質問に関する情報を外部データベースから探し出し、その情報も含めて回答することができます。

つまり、通常GPT等のLLM(大規模言語モデル)単独では社内情報や専門性の高い情報には正しく回答できませんが、RAGの仕組みを取り入れることで、社内情報等にも回答できるようになります。RAGを実装することで、貴社専用の生成AIとして業務活用できるだけでなく、ハルシネーションの低減にも繋がります。

RAGの詳しい仕組みにつきましては、解説記事を公開していますので、併せてご覧ください。

Allganizeが公開したRAG Leaderboardは、主要なRAGシステムの回答性能を数値的に比較したスコア一覧表です。今回のAllganize RAG Leaderboardでは、企業が利用する可能性のある主要なRAGソリューションをピックアップして比較しています。

どのようにスコアを算出したのか、次のセクションから詳しく説明します。

2. RAG Leaderboardの評価対象

RAG Leaderboardでは、共通のテストデータセットを用意し、同じ質問をした場合の回答内容の正確性を評価しています。

RAGシステムで回答生成するプロセスは、大きく3つに分けられます。

(1)ドキュメントをAIが検索しやすいデータ形式に変換(Parser)

ドキュメント類から文字・図・表などを抽出し、AIが読みとりやすいデータ形式(フォーマット)に変換します。このフォーマット変換が、後述のプロセスの精度にも関与します。

(2)質問に関連する情報をデータベースから抽出(Retriever)

ユーザーの質問を受け、企業が保有する膨大なデータの中から回答となる情報を検索し、抽出します。前述のParserで検索しやすい状態になっていることや、検索するAIの精度が抽出精度に関わります。

(3)抽出情報をもとに、回答を生成(Generation)

上述のRetrieverが抽出した情報と、LLM自身の学習データと合わせてLLMが回答を自動生成します。LLMの能力だけでなく、Retrieverの情報抽出精度が回答結果を左右します。

これらの3つのプロセスは、RAGとLLMの組み合わせで実現しています。同じドキュメントに対して同じ質問をしたとしても、RAGの仕組みやLLMの種類によって回答が異なります。

本RAG Leaderboardでは、主要なRAGとLLMをピックアップし、それぞれの回答性能を評価しています。

3. 評価の流れ

本RAG Leaderboardは、以下の流れで性能評価を行いました。

- 評価対象の各RAGシステムの検証環境を構築

- 評価用のデータセットを用意

- 各RAGシステムの回答生成結果を自動評価

- RAG Leaderboardとして公開

4. 評価対象のRAGソリューション

今回は、以下のRAGソリューションを評価対象としています。今後も評価対象を追加する予定です。

Alli(Alli LLM App Market)

Alliは、Allganizeが提供するRAGソリューションを含んだサービスの総称です。Parserは、ページ単位でAllganize Parserを使用して実装しました。RetrievalはHybrid Searchを使って実装しています。Generationのモデルは OpenAIのGPTシリーズ、Anthropic Claudeシリーズ、Allganizeが提供する日本語LLMや金融特化型モデルをはじめ、様々なモデルと連携できます。

LangChain

LangChainはLLMを活用したアプリケーションを開発するためのフレームワークです。LangChain RAG Quick Startをベースに性能を評価しています。ParserはPyPDFを使用しており、チャンクサイズとオーバーラップは、チュートリアル通り1,000と200に設定しました。RetrievalはOpenAI Embeddingを使用しています。GenerationはLangChainがサポートするモデルを自由に使用できます。

OpenAI Assistant

OpenAI Assistantは、File Search、Code Interpreterなどの特定の機能をサポートするツールです。文書をアップロードすることができ、独自のVector Storesに保存されます。質問を入力すると、Vector Storesから関連するチャンクを取得し、モデルに入力して回答を出力します。どのチャンクを使用したのかはCitation(引用)で確認できます。

Cohere

Cohereは、Text EmbeddingモデルとGenerationモデルを提供しています。ParserでCohereには文書をアップロードして解析する機能がないため、LangChainの基本Parserを使用しました。チャンクサイズは500で オーバーラップは200に設定しました。Cohereの埋め込み最大長が512トークンと相対的に短いため、短く設定しています。Retrievalは「embed-multilingual-v3.0」を使用し、Generationは「command-r」と「command-r-plus」を使って性能を評価しました。

AnythingLLM

AnythingLLMは、使用したいLLMとベクタDBを選択してRAGパイプラインをローカルに構築できるプログラムです。文書を「Workspace」というオブジェクトに分割します。各ワークスペースにアップロードされた文書のみを対象に会話を実行します。プログラムをダウンロードして使用することも、Githubコードをcloneしてdocker composeとして実行することもできます。ParserとRetrievalは、Anything LLM独自の方法で実装されています。Generation model は、OpenAI や Anthropic モデルの API key で利用しています。

5. 評価用のデータセットとは

各RAGソリューションの性能評価を行うために、「回答ソースとなるドキュメント集」と、ドキュメント集をもとに作成した「質問と正解回答のセット」を用意し、評価を行っています。

企業が業務で利用するドキュメントは、業種によって記載内容や書式などが異なります。そのため、以下の5つの業種について回答ソースのドキュメント集および質問と正解回答セットを準備しました。

<評価した業種>

・金融

・情報通信

・製造

・流通・小売

・公共

実際の業務で利用するドキュメントと同様、図表を含むドキュメントを使用しています。各業種に関連するドキュメントをそれぞれ12〜14種類用意し、各業種ごとに60個の質問と正解回答セットを作成しました。

使用したデータセットはHugging Face上で公開しておりますので、詳細をご確認いただけます。

6. 公平性を担保する、自動評価方法

客観的で公平な評価を行うために、自動性能評価方法を採用しています。

上記のデータセットを用い、それぞれの質問に対して各RAGソリューションが生成した回答について、4つのLLM Eval(測定ツール)を用いて評価しました。自動評価方法の技術手法に関しては、別記事で後日詳しくご紹介する予定です。

RAGソリューションが生成した回答と正解回答を比較し、生成された回答が正解かどうか4つのLLM Evalで測定し、3つ以上のツールが正解と判定した場合は"◯"、正解したツールが2つ以下の場合は"×"と評価しました。

自動評価方法の妥当性について、人が目視で評価した結果と自動評価の結果を比較したところ、誤差率は5%程度であり、有効な評価手法だと判断しています。

7. 評価結果について

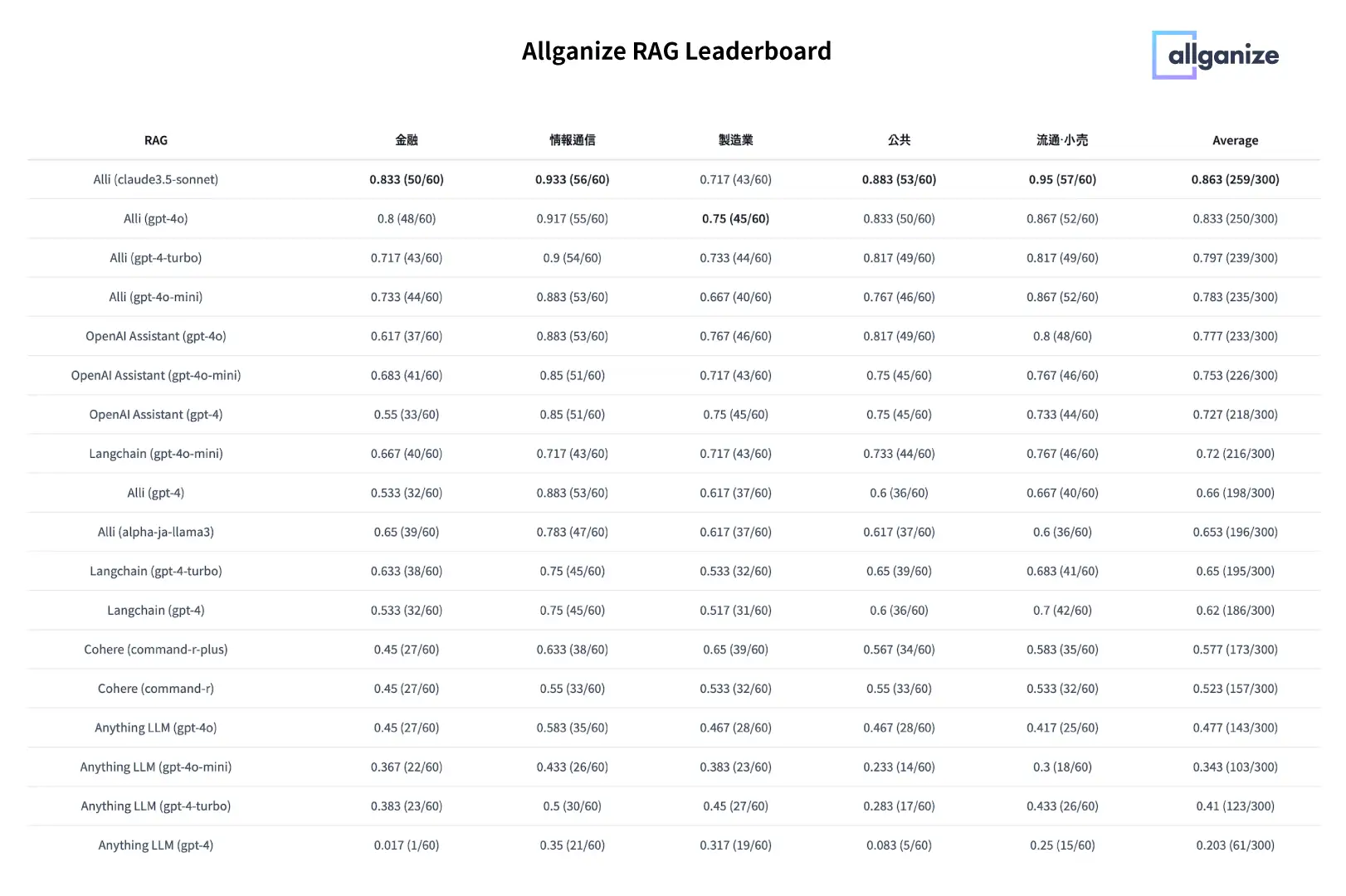

業種ごとに、「RAGソリューション+LLM」の組み合わせの回答内容を評価しました。

以下の表の一番左にRAGソリューションとLLMの組み合わせ、右側が業種ごとの性能評価をスコア化したもになります。スコア数値が高いほど正解回答が多く、回答性能が良いことを表します。

具体的な見方を確認してみましょう。左からRAGソリューションの種類、業種ごとのスコア、全業種の平均スコアが表示されています。

例えば、トップに表示されているものは、RAGソリューションはAllganizeのAlli、LLMはAnthropic Claude3.5 Sonnet、金融ドメインのスコアは0.833(60問中50問を正解)情報通信ドメインのスコアは0.933(60問中56問を正解)・・<略>・・全業界平均スコアは0.863(合計300問中259問を正解)という結果です。

一番右側に記載されている、全業界平均スコアの高い順に並んでいます。

8. 性能評価に大きく差が出る主な要因

上記の表を見ていただくと、上位と下位で正解回答数が大きく異なっていることが見て取れます。なぜ、このように大きく差が出るのでしょうか。

これには、企業が業務で取り扱うドキュメントの性質が関係しています。

冒頭でお話ししましたように、RAGを実現する技術はそれぞれ異なります。企業が日常的に取り扱うデータは、図や表も含まれる複雑なドキュメントが多く、情報抽出の難易度が高い傾向にあります。特に、図や表に記載されている情報を抽出できるか否かで、回答精度に大きく差が開きました。

また、長文のドキュメントの場合、質問に対する情報を精度高く抽出するためには、上述したRAGのParserのプロセスで文脈を正しく把握できるようなデータ処理を施すことも重要です。

RAGの鍵となる、ParserからRetrieverの仕組みにつきましては、以下のブログ記事で詳しく説明しています。ぜひご覧ください。

9. RAG Leaderboardの活用

企業の生成AI活用において、社内情報などから回答を生成するためにRAGは必要不可欠な技術となっています。これまでご紹介しましたように、実装するRAGシステムによって回答精度も大きく異なりますので、事前確認も重要です。

性能表と回答詳細をもとに、各RAGの性能をすぐに確認

お客様が自社の業務に適したRAGを評価するためには、検証環境の構築、評価用の大量のデータセットが最低限必要となりますが、RAGに精通した専門人材、対応工数、各種費用が求められます。

AllganizeのRAG Leaderboardでは、スコア一覧のみならず、ソースとなるドキュメントと回答内容を詳細に確認いただくことができます。本Leaderboardをご覧いただくことで、自社で環境を用意することなく、様々なRAGソリューションの回答性能を確認いただけます。

公開データセットをもとに、検証環境をスピーディに準備

検証環境を自前で構築し詳細検証を行う場合も、本RAG Leaderboardを活用いただくと、スピーディに検証を開始いただけます。

環境構築はもちろんのこと、ドキュメント収集や質問・回答のデータセット作成にも相当数の工数を要します。

また、自動評価の設定情報もHugging FaceのRAG Leaderbordページに詳細を公開しておりますので、同様の性能評価をお客様にて実施いただくことが可能です。

データセット等の詳細はHugging Faceページをご覧ください。(日本語で記載しています)

10. RAGソリューション「Alli」の回答性能が高い理由

今回のRAG Leaderboardの平均スコアトップはAllganizeのRAGソリューション「Alli」という結果になりました。

Allganizeは、独自技術を用いて、企業用途に特化したRAGシステムを開発しており、それが今回の高スコアに繋がったと考えています。

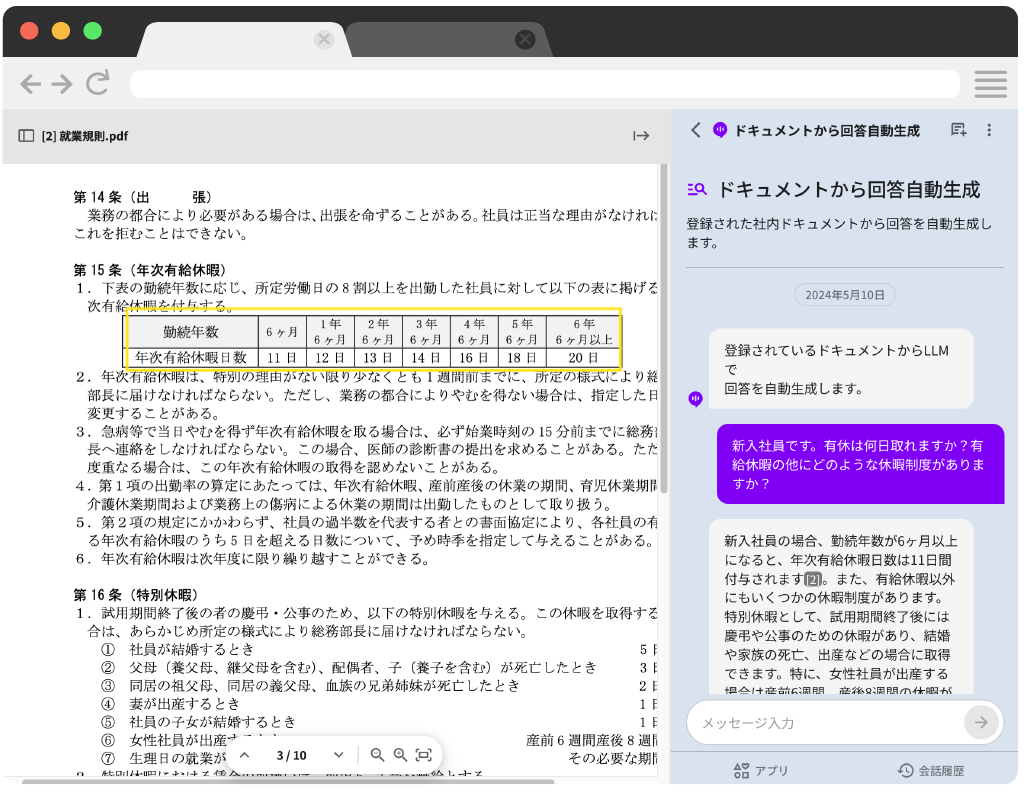

AllganizeのRAGの特徴的な点は、図表からの回答生成です。

表形式(テーブル形式)のデータに関しては、Parserの段階でテーブルを崩さずデータを処理する特許技術を採用しています。ご存知のように、表データはヘッダーや項目を正しく認識できないと意味が損なわれてしまいます。AllganizeのRAGは、テーブルデータをそのままAIが認識できるため、表に記載されている情報からも精度高く回答できます。

図に関しても、Parserの段階でドキュメントに含まれる画像もAIが認識できるようにデータ処理しているため、イメージ図などの画像に含まれている情報からも回答を生成します。

図表からの回答生成は難易度が高く、全体的なスコアにも顕著に表れました。

AllganizeのRAGが表から回答生成する仕組みも、本記事で詳しくご紹介しています

11. AllganizeのRAG、3つのメリット

メリット①: 貴社専用の生成AI活用環境として、全社的な業務の高度化に貢献

貴社情報から回答する方法として、LLMのチューニングという選択肢もありますが、コストも時間も要します。また、新たな情報に対応させるには再チューニングも必要です。

AllganizeのRAGは、上述の通り図表にも対応しているため、さまざまな業務に適応できます。回答精度も高いため、既存のLLMにRAGを組み合わせていただくだけで、専用の生成AI環境を実現します。

また、実際に企業が業務でご利用される際には、Retrieverの精度を個社ごとに最適化できます。最適化に関する専門知識も不要で、運用も容易です。

AllganizeのRAGを導入いただくと、貴社専用の生成AIとして、業務の高度化や生産性向上に大きく貢献します。

メリット②: SaaSからオンプレミスまで、セキュリティポリシーに合わせた環境でご提供

AllganizeのRAGソリューションは、企業の生成AI活用に必要な全ての要素をオールインワンで提供する生成AI・LLMアプリプラットフォーム「Alli LLM App Market」の回答自動生成アプリに標準実装されています。

クラウドサービスで最短1日で即利用できるほか、セキュリティポリシーに合わせて、プラプライベートクラウド、オンプレミスでご利用いただけます。貴社環境のLLMに連携するなど、柔軟な運用が可能です。

オンプレミスで利用する場合、RAGや生成AIアプリプラットフォームだけでなく、日本語LLMも合わせて提供いたします。貴社環境のLLMに連携することも可能です。

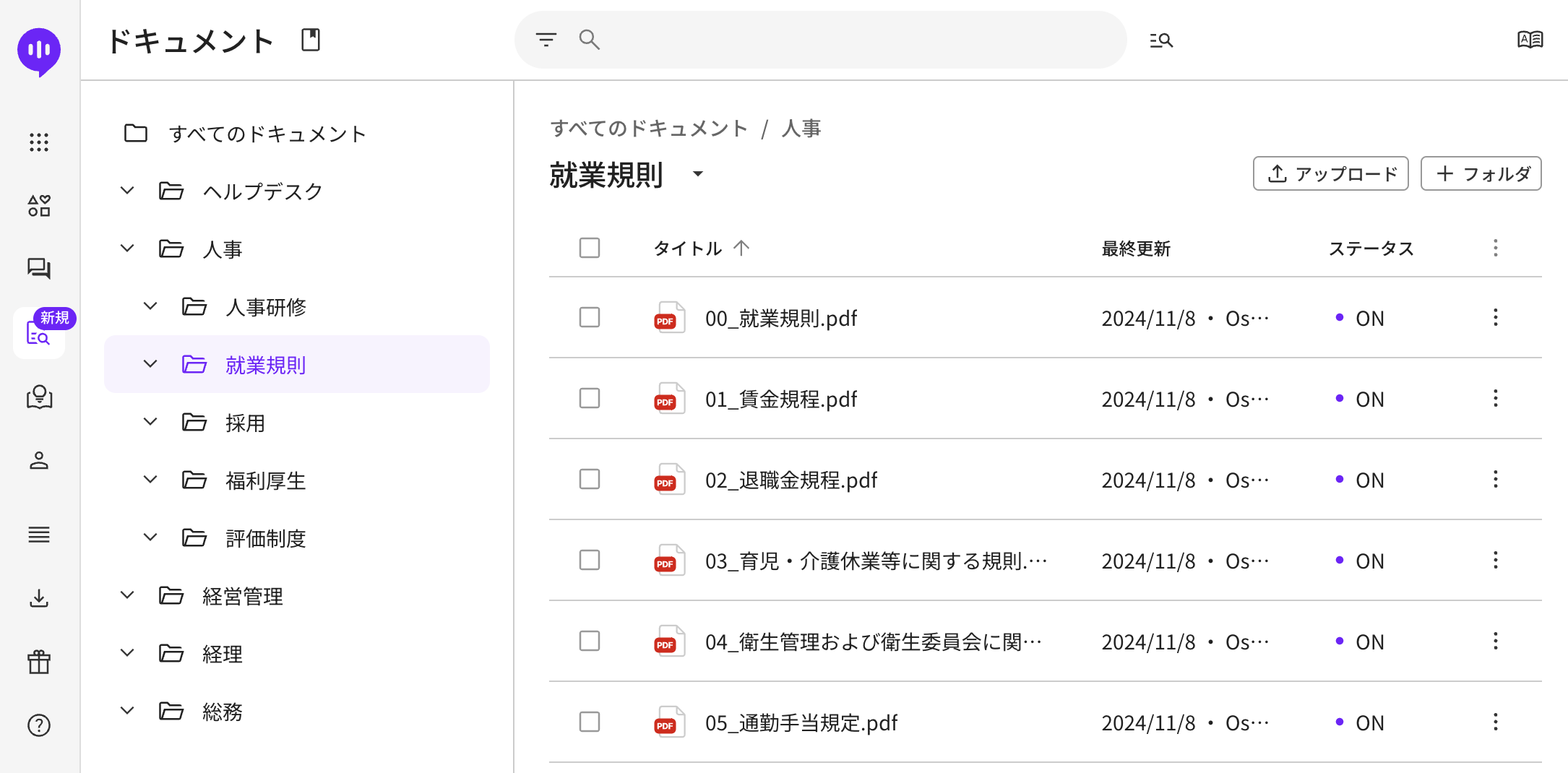

メリット③: 専門知識は不要。現場部署で対象ドキュメントのメンテナンスが可能

AllganizeのRAGソリューションでは、わかりやすい管理画面も用意しています。

求める情報をすぐに確認できることが、RAGシステムの最大の価値です。せっかくRAGシステムを用意しても、対象ドキュメントが古いままでは、導入効果は限られてしまいます。

AllganizeのRAGソリューションは、現場部署でも簡単にRAG対象ドキュメントを管理できるよう、直感的に操作できるUXを追求しています。

新しい情報から回答させたい場合は、新しいドキュメントを追加し、古いドキュメントデータのステータスをOffまたは削除するだけで、メンテナンスが完了します。

SharePoint、Googleドライブなどの外部ドライブと連携することも可能です。

12. 企業向けRAG戦略、成功のための3つのポイント[ホワイトペーパー]

RAGの仕組みから、企業の複雑なドキュメントでも高精度で回答できる「成功する企業のRAG戦略」3つのポイントをご紹介したホワイトペーパーをご用意しております。

RAGにおけるデータ管理などを詳しくご紹介しておりますので、ぜひご覧ください。

13. 生成AIやRAGの企業活用に関する個別相談会を開催中!

Allganizeでは、生成AIやRAGの企業活用に関する個別相談会を開催しております。RAGを活用した生成AI活用のご提案、ユースケースなどを個別にご案内しております。

日程などをご案内いたしますので、お気軽にお問い合わせフォームからご連絡ください。

関連リンク